学习

调用

jadx批量反编译

语音识别

codeforces

collections

分享

激光测距传感器

CyclicBarrier

kernel

泰勒展开式

中医

vuex

laravel

docker 搭建es

读书笔记

代码维护

Spark sql

最小二乘法

获客

FlinkCDC

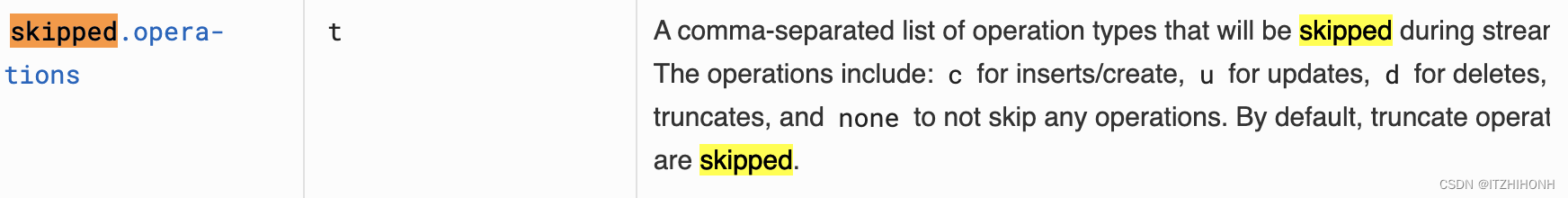

2024/4/13 20:25:01FlinkCDC系列:通过skipped.operations参数选择性处理新增、更新、删除数据

在flinkCDC源数据配置,通过debezium.skipped.operations参数控制,配置需要过滤的 oplog 操作。操作包括 c 表示插入,u 表示更新,d 表示删除。默认情况下,不跳过任何操作,以逗号分隔。配置多个操作ÿ…

FlinkCDC系列:数据同步对部分字段的处理,只更新部分字段

在flinkCDC源数据配置中,只对表中的部分字段关注,通过监控部分字段进行数据更新或者不更新,对数据进行同步。主要通过以下两个参数:

column.exclude.list

默认: 空字符串

一个可选的、以逗号分隔的正则表达式列表,与…

FlinkCDC能读取到快照,但是无法输出更新数据

FlinkCDC能读取到快照,但是无法输出更新数据 发现是并行度问题,当我的并行度超过1的时候就无法捕获更新。目前并没有找到具体原因,只能单独设定并行度。 如有大佬路过求告知。

public static void main(String[] args) throws Exception {Sy…

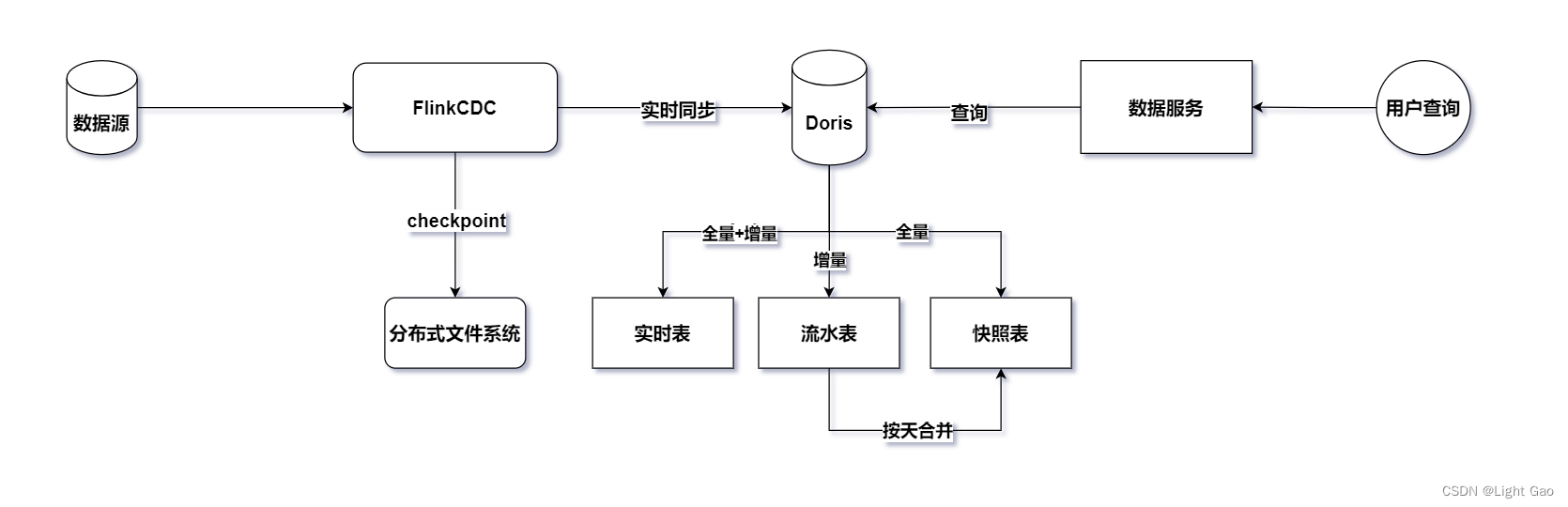

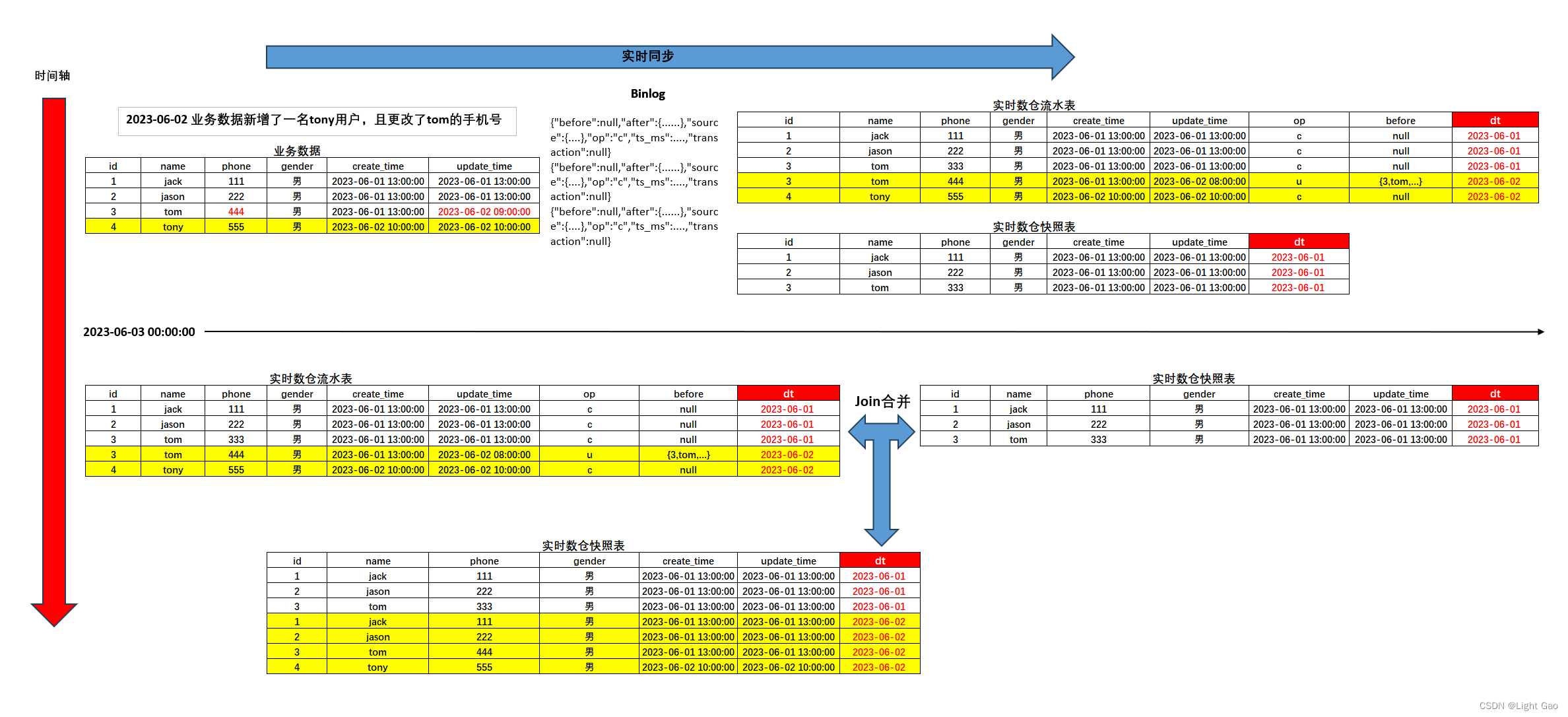

Flink实时数仓同步:实时表、流水表、快照表整合实战详解

一、背景

在大数据领域,数据分析、实时数仓已经成为平台上常见的功能之一。无论是进行实时分析还是离线分析,都离不开数仓中的表数据。

特别是在实时分析领域,查阅实时数据、历史数据以及历史变更数据是非常常见的需求。而这些功能的实现主…

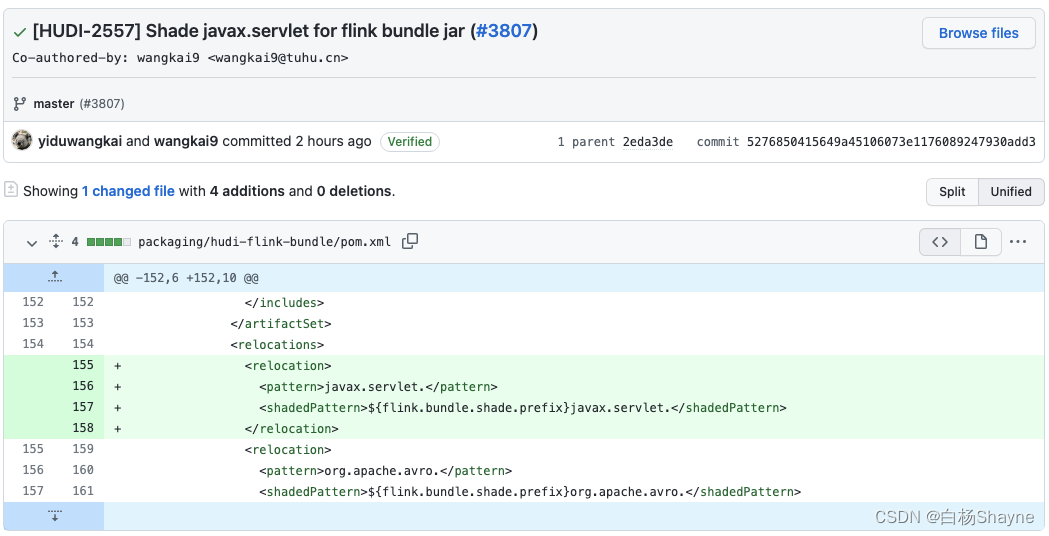

使用Flink MySQL cdc分别sink到ES、Kafka、Hudi

环境说明 [flink-1.13.1-bin-scala_2.11.tgz](https://archive.apache.org/dist/flink/flink-1.13.1/flink-1.13.1-bin-scala_2.11.tgz)[hadoop-2.7.3.tar.gz](https://archive.apache.org/dist/hadoop/common/hadoop-2.7.3/hadoop-2.7.3.tar.gz)[flink-cdc-connectors](https:…

FlinkCDC菜鸟教程/演示 MongoDB基于Flink CDC 导入 Elasticsearch

演示: MongoDB基于Flink CDC 导入 Elasticsearch 下载 docker-compose.yml version: 2.1

services:mongo: image: "mongo:4.0-xenial" command: --replSet rs0 --smallfiles --oplogSize 128 ports: - "27017:27017" environment: - MONGO…

flinkcdc同步完全量数据就不同步增量数据了

flinkcdc同步完全量数据就不同步增量数据了

使用flinkcdc同步mysql数据,使用的是全量采集模型 startupOptions(StartupOptions.earliest()) 全量阶段同步完成之后,发现并不开始同步增量数据,原因有以下两个:

原因1: …

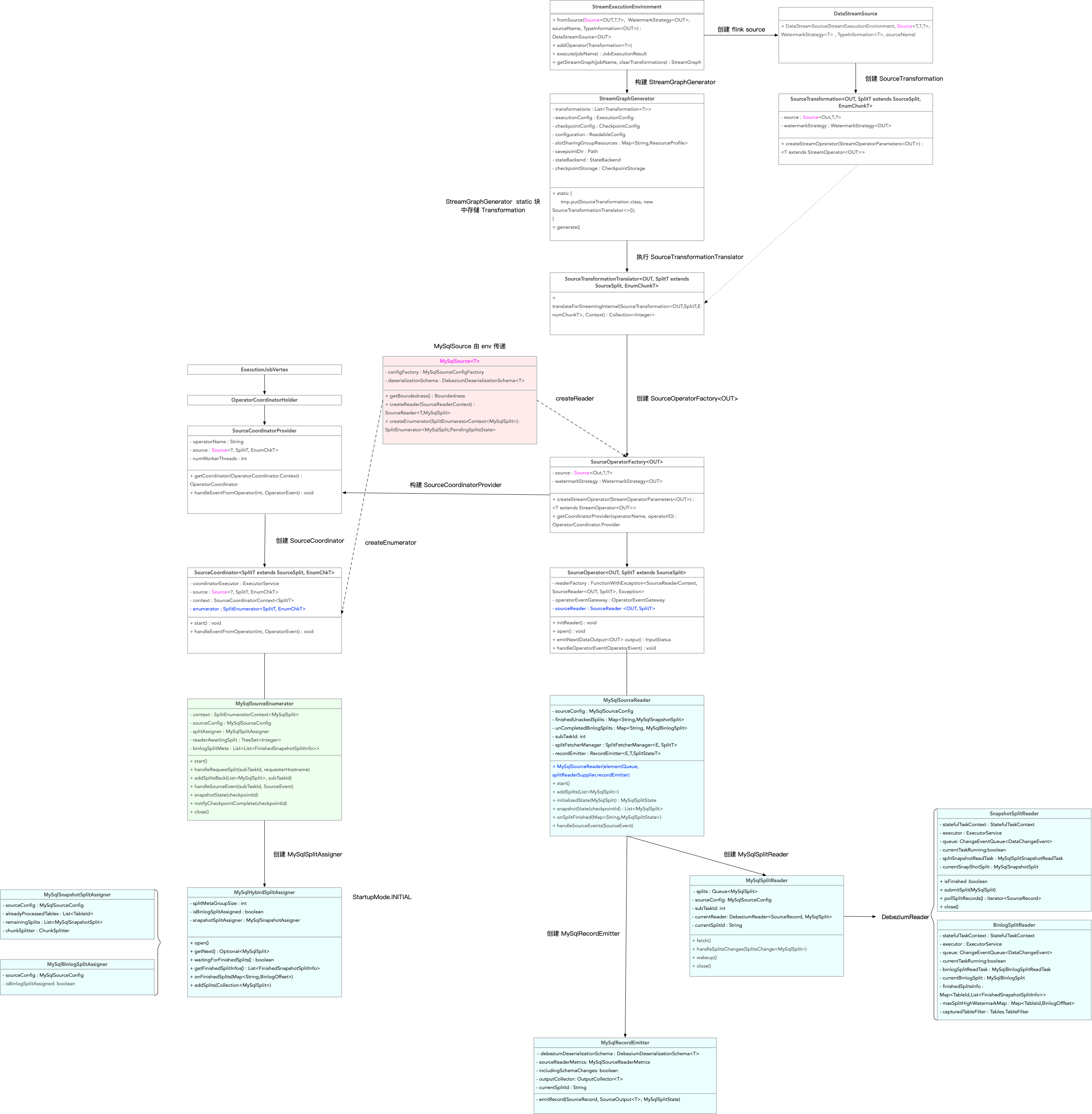

深入解析 Flink CDC 增量快照读取机制

一、Flink-CDC 1.x 痛点

Flink CDC 1.x 使用 Debezium 引擎集成来实现数据采集,支持全量加增量模式,确保数据的一致性。然而,这种集成存在一些痛点需要注意: 一致性通过加锁保证:在保证数据一致性时,Debez…

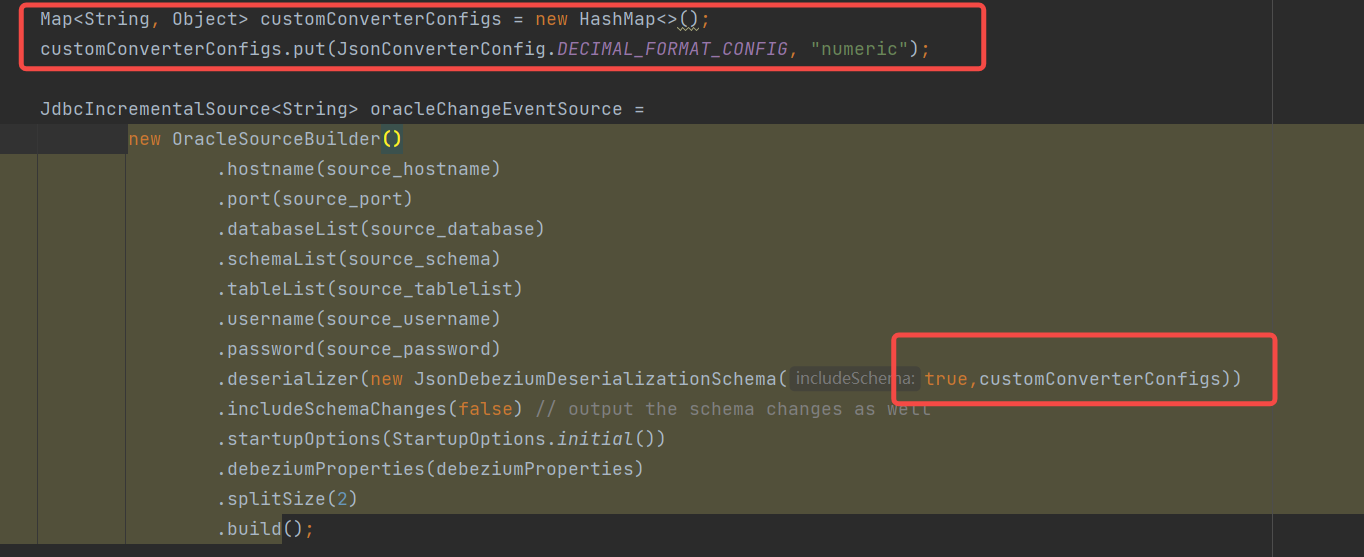

flinkcdc数据采集代码FlinkAPI

1. flinkcdc数据采集代码:

背景

使用flinkcdc采集mysql数据到kafka,经过长达两个月的各种调试,终于把调试后的版本给写出来了,进行的全量加增量的数据采集,并写了一个窗口,每隔10min中更新一次每张表同步…

Flink实时数仓同步:快照表实战详解

一、背景

在大数据领域,初始阶段业务数据通常被存储于关系型数据库,如MySQL。然而,为满足日常分析和报表等需求,大数据平台采用多种同步方式,以适应这些业务数据的不同存储需求。这些同步存储方式包括离线仓库和实时仓…

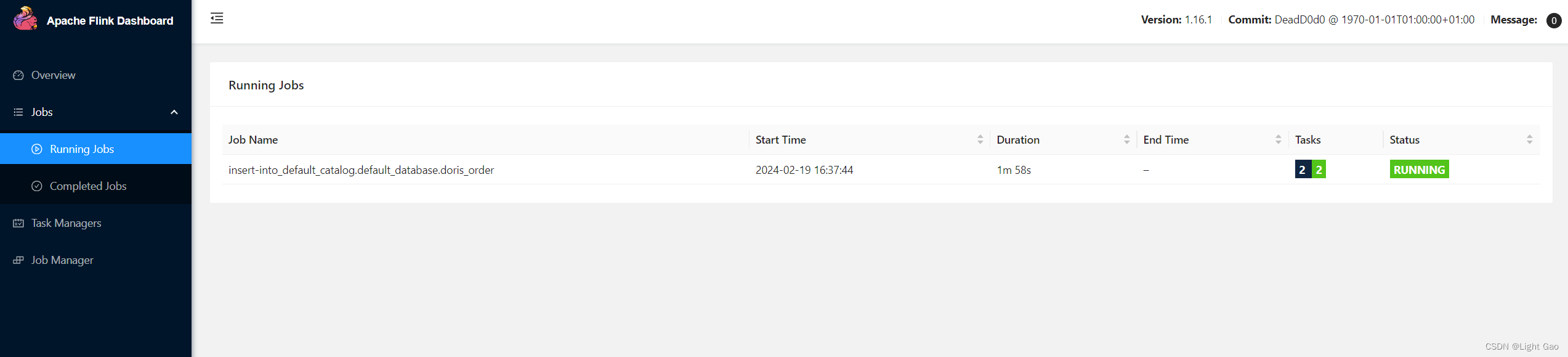

flinkcdc 3.0 尝鲜

本文会将从环境搭建到demo来全流程体验flinkcdc 3.0 包含了如下内容 flink1.18 standalone搭建doris 1fe1be 搭建整库数据同步测试各同步场景从检查点重启同步任务 环境搭建

flink环境(Standalone模式)

下载flink 1.18.0 链接 : https://archive.apache.org/dist/flink/flink…

flinkcdc 体验

0 flink版本 踩雷

java代码操作 flink Table/SQL API 和 DataStream API 编写程序后,打成jar包丢到flink集群运行,报错首选需要考虑flink集群版本和 jar包中maven依赖的版本是否一致。 目前网上flink、flinkcdc相关博文绝大部分是基于flink1.13、1.14编…

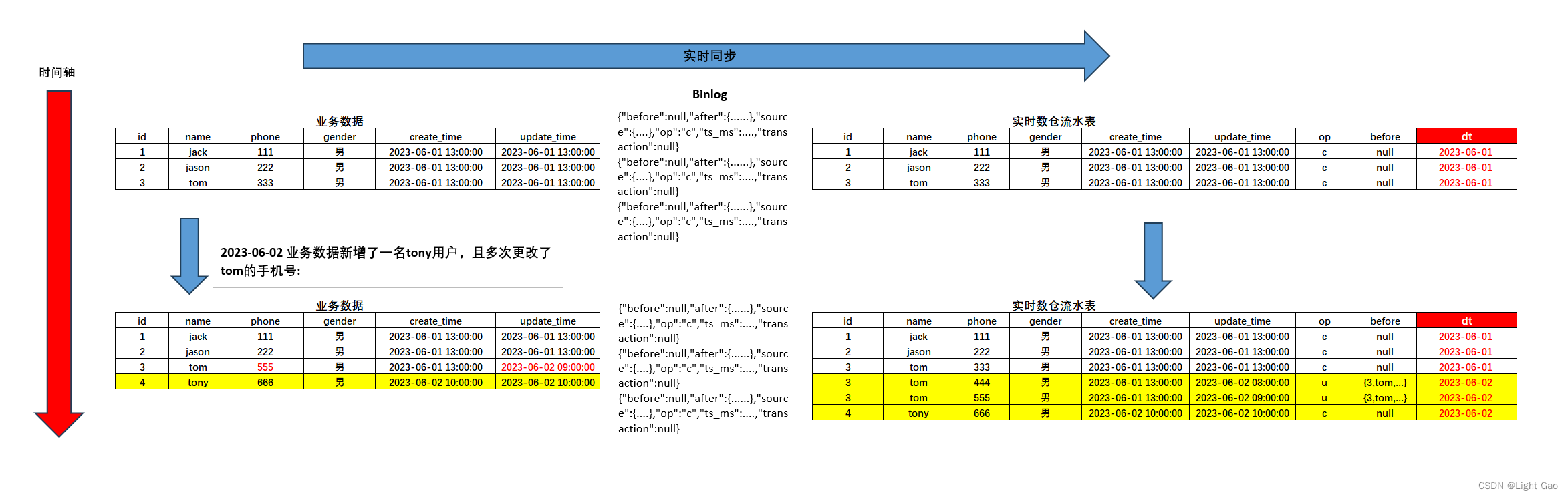

Flink实时数仓同步:流水表实战详解

一、背景

在大数据领域,初始阶段业务数据通常被存储于关系型数据库,如MySQL。然而,为满足日常分析和报表等需求,大数据平台采用多种同步方式,以适应这些业务数据的不同存储需求。这些同步存储方式包括离线仓库和实时仓…

Flink CDC 菜鸟教程 -环境篇

本教程将介绍如何使用 Flink CDC 来实现这个需求, 在 Flink SQL CLI 中进行,只涉及 SQL,无需一行 Java/Scala 代码,也无需安装 IDE。 系统的整体架构如下图所示: 环境篇

1、 准备一台Linux

2、准备教程所需要的组件

下载 flink-1.13.2 并将其解压至目录 flink-1.13.2 …

Flink实时数仓同步:切片表实战详解

一、背景

在大数据领域,初始阶段业务数据通常被存储于关系型数据库,如MySQL。然而,为满足日常分析和报表等需求,大数据平台采用多种同步方式,以适应这些业务数据的不同存储需求。

一项常见需求是,业务使用…

FlinkCDC原理全面理解和应用

目录

1.CDC简介

1.1 什么是CDC

1.2 CDC的种类

1.3 Flink-CDC

2.FlinkCDC案例实操

2.1 DataStream方式的应用

flinkcdc踩坑指南

文章目录 前言一、常见问题1.No suitable driver found for jdbc:oracle:thin:10.101.37.167:8888/orclpdb2.The db history topic or its content is fully or partially missing. Please check database history topic configuration and re-execute the snapshot3.com.verve…

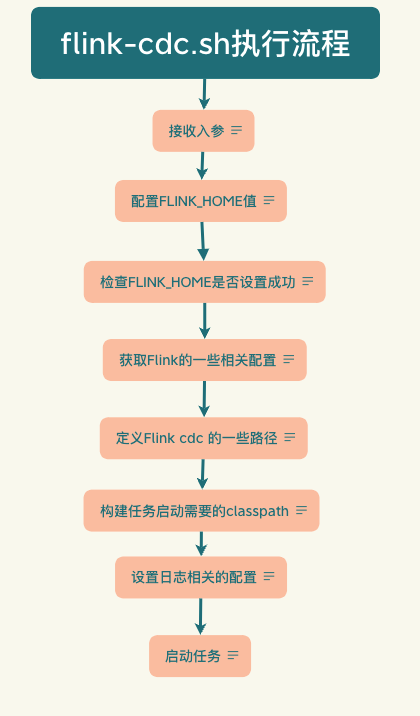

flinkcdc 3.0 源码学习之任务提交脚本flink-cdc.sh

大道至简,用简单的话来描述复杂的事,我是Antgeek,欢迎阅读. 在flink 3.0版本中,我们仅通过一个简单yaml文件就可以配置出一个复杂的数据同步任务, 然后再来一句 bash bin/flink-cdc.sh mysql-to-doris.yaml 就可以将任务提交, 本文就是来探索一下这个shell脚本,主要是研究如何通…